Google erweitert Android: Neue Features für bessere Zugänglichkeit und Inklusion

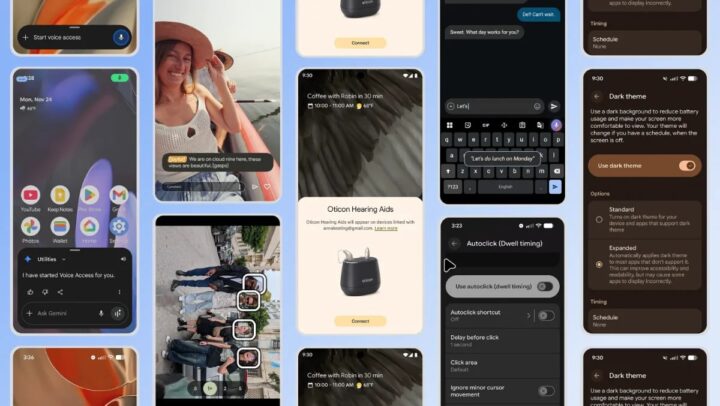

Google nutzt den internationalen Tag der Menschen mit Behinderungen, um das Feature-Set von Android ordentlich zu erweitern. Der Fokus liegt dabei auf Zugänglichkeit und Inklusion. Insgesamt sieben Neuerungen sollen die Bedienung des Smartphones erleichtern, das reicht von der visuellen Darstellung über die Eingabe bis hin zur Audio-Verarbeitung.

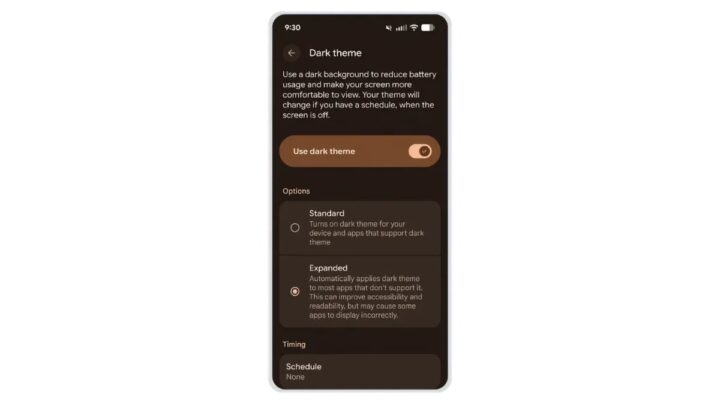

Eine Anpassung betrifft die visuelle Ausgabe bei Apps, die von Haus aus keinen Darkmode unterstützen. Mit einer neuen Option in Android 16 ist das System in der Lage, ein dunkles Design auf nahezu jede Anwendung zu erzwingen. Dies verhindert den harten Kontrastwechsel, wenn Nutzer von einer abgedunkelten Systemoberfläche in eine App mit grell weißem Hintergrund wechseln.

Im Audio-Bereich führt Google die „Expressive Captions“ ein. Hierbei kommt natürlich KI zum Einsatz, um Untertitel informativer zu gestalten. Statt den Text starr wiederzugeben, analysiert das System die Intonation. Emotionen werden durch Tags wie [Freude] oder [Traurigkeit] markiert, während die Lautstärke oder Betonung durch Großschreibung visualisiert wird. Auch Umgebungsgeräusche oder Seufzer finden Einzug in die Textdarstellung. Diese Funktion wird zu Beginn erst einmal bei englischsprachigen Inhalten auf YouTube implementiert.

Für Nutzer, die Android-Geräte mit einer externen Maus bedienen sollten, wurde die AutoClick-Funktionalität überarbeitet. Um die physische Belastung durch ständiges Klicken zu reduzieren, lässt sich nun eine Verweildauer für den Cursor festlegen, nach deren Ablauf eine Aktion automatisch ausgelöst wird. Ein neues Auswahl-Panel ermöglicht dabei die Definition der gewünschten Aktion:

- Linksklick

- Rechtsklick

- Doppelklick

- Drag-and-Drop

- Scrollen

Parallel dazu erhält „Voice Access“ ein Update für die freihändige Nutzung. Die Funktion lässt sich neuerdings direkt über den Sprachbefehl aktivieren. Neben einer verbesserten Erkennung von Akzenten und Satzzeichen können jetzt auch Systemfunktionen wie WLAN oder Bluetooth per Sprachbefehl gesteuert werden.

Die KI-Modelle von Google greifen stärker in die Assistenzsysteme ein. In der Pixel-Kamera-App wird die „Guided Frame“-Funktion erweitert. Wo bisher lediglich Gesichter erkannt wurden, liefert die Software ab sofort detaillierte Szenenbeschreibungen. Die Audio-Ausgabe beschreibt beispielsweise Kleidung, Objekte im Hintergrund oder Interaktionen zwischen Subjekten im Bildausschnitt.

Auch die TalkBack-Funktion profitiert von der KI-Anbindung. Über eine neue Geste – ein Doppeltipp mit zwei Fingern – lässt sich in Gboard die Diktierfunktion starten. Gemini ermöglicht hierbei das kontextbezogene Editieren. Befehle wie „Ersetze Montag durch Dienstag“ oder Aufforderungen zum Kürzen des Textes werden in natürlicher Sprache verarbeitet und umgesetzt.

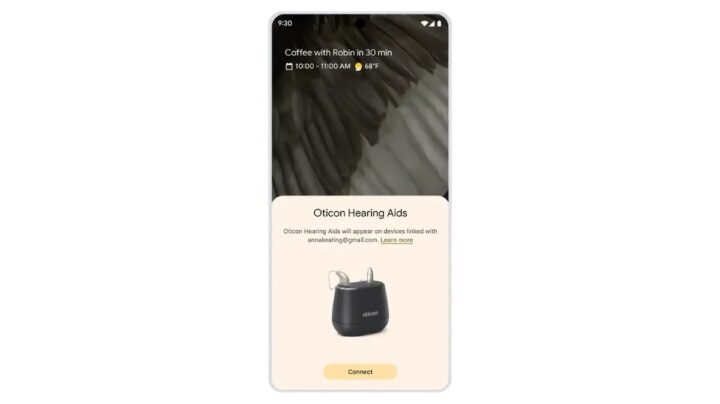

Abschließend vereinfacht Google die Kopplung von Hörgeräten. Modelle, die Bluetooth LE Audio unterstützen, können via „Fast Pair“ mit einem einzigen Tippen verbunden werden. Den Anfang machen Geräte des Herstellers Demant; kompatible Modelle von Starkey sollen Anfang 2026 folgen.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Abseits dieser Funktionen: Es ist schon krass, wie viel leichter das Leben in Zukunft für Behinderte wird – auf eine Weise, die vor wenigen Jahren noch undenkbar war. Taub? VR-Brille mit live generierten Untertiteln. Blind? Vorlesen Dank KI auf einem völlig neuen Niveau, inkl. Zusammenfassungen und Nachfragen. Motorisch eingeschränkt? Roboter und Kameraüberwachung durch KI im Falle eine Notfalls. Einkaufen, kochen, Kommunikation … alles wird massiv erleichtert, vielleicht abgesehen vom Anziehen. Tolle Entwicklung, auch für Angehörige.

Ich nutze die Hörgerätefunktion der Airpods Pro 3. Seit dem ich die Habe liegen die Kassenhörgeräte nur in der Schublade. Schon krass, dass Geräte für 250€ besser funktionieren als Kassenhörgeräte die 1000€ pro Ohr kosten (gut hab 10€ pro Seite bezahlt).

Hallo Celli,

das habe ich noch nie ausprobiert – ich muß seit einigen jahren auch beidseitig Hörgeräte tragen . Da ich auch nichts sehe , war die Anpassung nicht unkritisch: die geräte müssen nicht nur das Sprachverstehen verbessern, sondern dürfen vor allem das räumliche Hören nicht stören.

Was für Sehende meist durch den Sehsinnn „kaschiert“ wird: hörgeräte verzerren das räumliche Hörfeld drastisch – ihre Mikrofone sitzen ja quasi zwischen ohrmuschel und Schädel – und nicht wie natürlicherweise im Gehörgang.

Alle einflüsse auf das Hörfeld durch Ohrmuschel und Gehörgang sind also futsch.

Bei mir hat eine sehr offene Anpassung gehholfen: da ich nur im Hochtonbereich Verluste habe, tiefe Frequenzen aber „noch wie ein junger höre“ (Aussage meines ohrenarztes) konnten wir das so einstellen daß ich noch viel über das natürliche Hörfeld bekomme und so im Straßenverkehr auch mit Hörgerät sicher agieren kann.

Wie natürlich ist denn Einem Eindruck nach das Hörfeld mit den Apple-Hörern?

Fühltest Du dich z. B. sicher genug, eine Straße zu überqueren , weil du sicher einordnen kannst von wo ein herannahendes Motorgeräusch kommt?